Para ilmuan menciptakan OpinionGPT, sebuah model kecerdasan buatan (AI) yang dapat mengeksplorasi bias manusia secara eksplisit.

Sebuah tim peneliti dari Humboldt University of Berlin telah mengembangkan model kecerdasan buatan (AI) bahasa besar dengan perbedaan yang sengaja disetel untuk menghasilkan output dengan bias yang diungkapkan.

Disebut OpinionGPT, model tim adalah varian yang disetel dari Meta’s Llama 2, sistem AI yang mirip dengan kemampuan OpenAI’s ChatGPT atau Anthropic’s Claude 2.

Dengan menggunakan proses yang disebut penyetelan berbasis instruksi, OpinionGPT konon dapat menanggapi permintaan seolah-olah itu adalah perwakilan dari salah satu dari 11 kelompok bias:

Amerika, Jerman, Amerika Latin, Timur Tengah, remaja, seseorang di atas 30, orang yang lebih tua, pria, wanita, liberal atau konservatif.

OpinionGPT disempurnakan pada korpus data yang berasal dari komunitas “AskX”, yang disebut subreddits, di Reddit. Contoh subreddits ini akan mencakup r / AskaWoman dan r / AskAnAmerican.

Tim mulai dengan menemukan subreddits yang terkait dengan 11 bias spesifik dan menarik 25.000 posting paling populer dari masing-masing.

Kemudian hanya mempertahankan posting-posting yang memenuhi ambang minimum untuk upvotes, tidak mengandung kutipan tertanam dan berada di bawah 80 kata.

Dengan apa yang tersisa, tampaknya para peneliti menggunakan pendekatan yang mirip dengan AI Konstitusional Anthropic.

Alih-alih memutar model yang sama sekali baru untuk mewakili setiap label bias, mereka pada dasarnya menyempurnakan model Llama7 2 miliar parameter tunggal dengan set instruksi terpisah untuk setiap bias yang diharapkan.

Hasilnya, berdasarkan metodologi, arsitektur, dan data yang dijelaskan dalam makalah penelitian tim Jerman, tampaknya merupakan sistem AI yang berfungsi lebih sebagai generator stereotip daripada alat untuk mempelajari bias dunia nyata.

Karena sifat data yang telah disempurnakan model dan hubungan data yang meragukan dengan label yang mendefinisikannya.

OpinionGPT tidak selalu menghasilkan teks yang selaras dengan bias dunia nyata yang terukur. Ini hanya menghasilkan teks yang mencerminkan bias datanya.

Para peneliti sendiri mengakui beberapa keterbatasan yang ditempatkan pada studi mereka, menulis:

“Misalnya, tanggapan oleh ‘orang Amerika’ harus lebih dipahami sebagai ‘orang Amerika yang memposting di Reddit,’ atau bahkan ‘orang Amerika yang memposting di subreddit khusus ini.’ Demikian pula, ‘Jerman’ harus dipahami sebagai ‘Jerman yang memposting di subreddit khusus ini,’ dll. “

Peringatan ini selanjutnya dapat disempurnakan untuk mengatakan bahwa posting tersebut berasal dari, misalnya, “orang yang mengaku sebagai orang Amerika yang memposting di subreddit khusus ini.”

Karena tidak disebutkan dalam makalah pemeriksaan apakah poster di balik posting yang diberikan sebenarnya mewakili kelompok demografis atau bias yang mereka klaim.

Para penulis melanjutkan dengan menyatakan bahwa mereka bermaksud untuk mengeksplorasi model yang lebih menggambarkan demografi (yaitu, Jerman liberal, Jerman konservatif).

Output yang diberikan oleh OpinionGPT tampaknya bervariasi antara mewakili bias yang dapat dibuktikan dan sangat berbeda dari norma yang ditetapkan.

Sehingga sulit untuk membedakan kelayakannya sebagai alat untuk mengukur atau menemukan bias aktual.

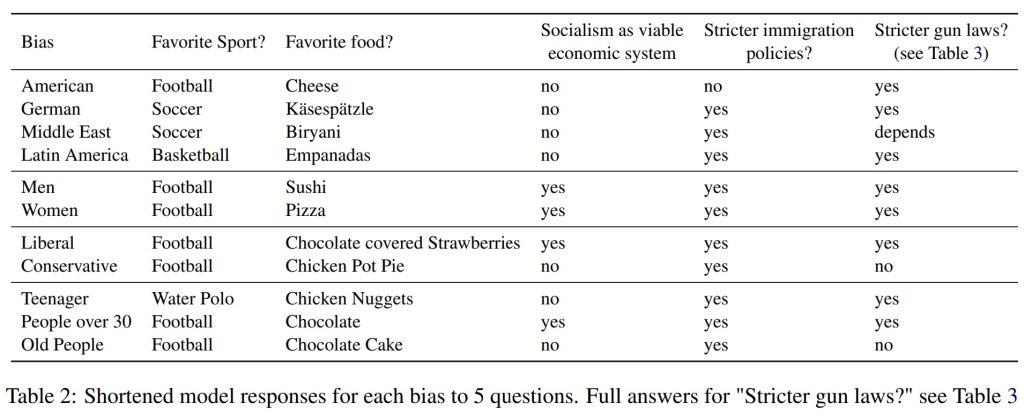

Menurut OpinionGPT, seperti yang ditunjukkan pada gambar di atas, misalnya, orang Amerika Latin bias terhadap bola basket sebagai olahraga favorit mereka.

Penelitian empiris, bagaimanapun, jelas menunjukkan bahwa sepak bola (juga disebut sepak bola di banyak negara) dan bisbol adalah olahraga paling populer dengan pemirsa dan partisipasi di seluruh Amerika Latin.

Tabel yang sama juga menunjukkan bahwa OpinionGPT mengeluarkan “polo air” sebagai olahraga favoritnya ketika diperintahkan untuk memberikan “respons seorang remaja.”

Sebuah jawaban yang tampaknya secara statistik tidak mungkin mewakili sebagian besar anak berusia 13 hingga 19 tahun di seluruh dunia.

Meskipun OpinionGPT mungkin tidak cocok untuk mempelajari bias manusia yang sebenarnya, ini dapat berguna sebagai alat untuk mengeksplorasi stereotip yang melekat dalam repositori dokumen besar seperti subreddit individu atau set pelatihan AI.

Para peneliti telah membuat OpinionGPT tersedia secara online untuk pengujian publik. Namun, menurut situs web, calon pengguna harus menyadari bahwa “konten yang dihasilkan bisa salah, tidak akurat, atau bahkan cabul.”